A mesterséges intelligencia megtévesztései ellen az emberi agy a leghatékonyabb fegyver

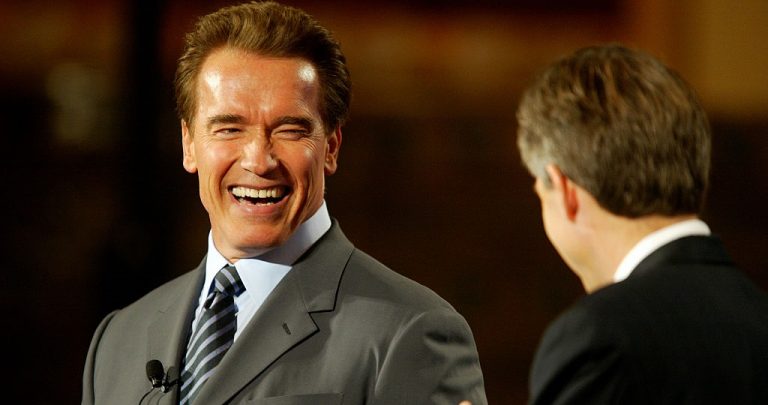

A deepfake-ek, vagyis mesterséges intelligencia programokkal generált, a valódihoz megtévesztésig hasonló, de mégsem létező emberek felismerésére és kiszűrésére léteznek módszerek, de a technológiai fejlődésével és az egyre kifinomultabb hamis képek/hangok megjelenésével egyre nehezebb dolga van az embereknek, ha szeretnék az igazit a hamistól megkülönböztetni. Míg a deepfake megjelenése idején, ami a mozifilmek szinkronizálását elősegítő Video Rewrite Program 1997-es kiadásakor érkezett el (bár magát a deepfake kifejezést jóval később, 2017-ben találta fel egy Reddit felhasználó), még egyértelmű volt, hogy a számítógéppel generált szájmozgás nem teljesen valós és így egy kis odafigyeléssel könnyen fel lehetett fedezni az árulkodó jeleket, de a mai, egyre részletesebb és realisztikusabb eredményt adó programok már sokszor egészen élethűen mutatnak be olyan arcokat, és eseményeket is, amelyek valójában sosem léteztek.

A felismerést az MIT Media Lab kutatója, Matthew Groh szerint bizonyos árulkodó jelek segíthetik, amelyeket bárki felfedezhet a videók alaposabb tanulmányozása során, ilyenek például:

- a túl gyakori, vagy éppen túl ritka pislogás

- a nem megfelelően illeszkedő haj vagy szemöldök

- a természetellenesen sima vagy túl ráncos arc

- a testalkathoz nem illő hang

- a felületekről különös szögben/módon visszatükröződő fény

A deepfake felismerés azonban a legélesebb szemű megfigyelőknek is nehézséget okozhat, a Groh és kutatótársai által 2021 decemberében publikált tanulmány szerint a vizsgálatban résztvevő 5524 alany nagy része ugyan a célzottan a deepfake szűrésre létrehozott számítógépes programoknál jobban teljesített és átlagban több mint 65%-os pontossággal tudták kiválasztani a hamis felvételeket, de bizonyos idő után minden egyes hezitálással töltött másodperc rontotta a teljesítményüket, átlagban 10 másodpercenként 1,1%-kal, vagyis a tudatos figyelem és az árulkodó jelek hosszabb ideig tartó kutatása nem segítette elő a helyes válasz megszületését.

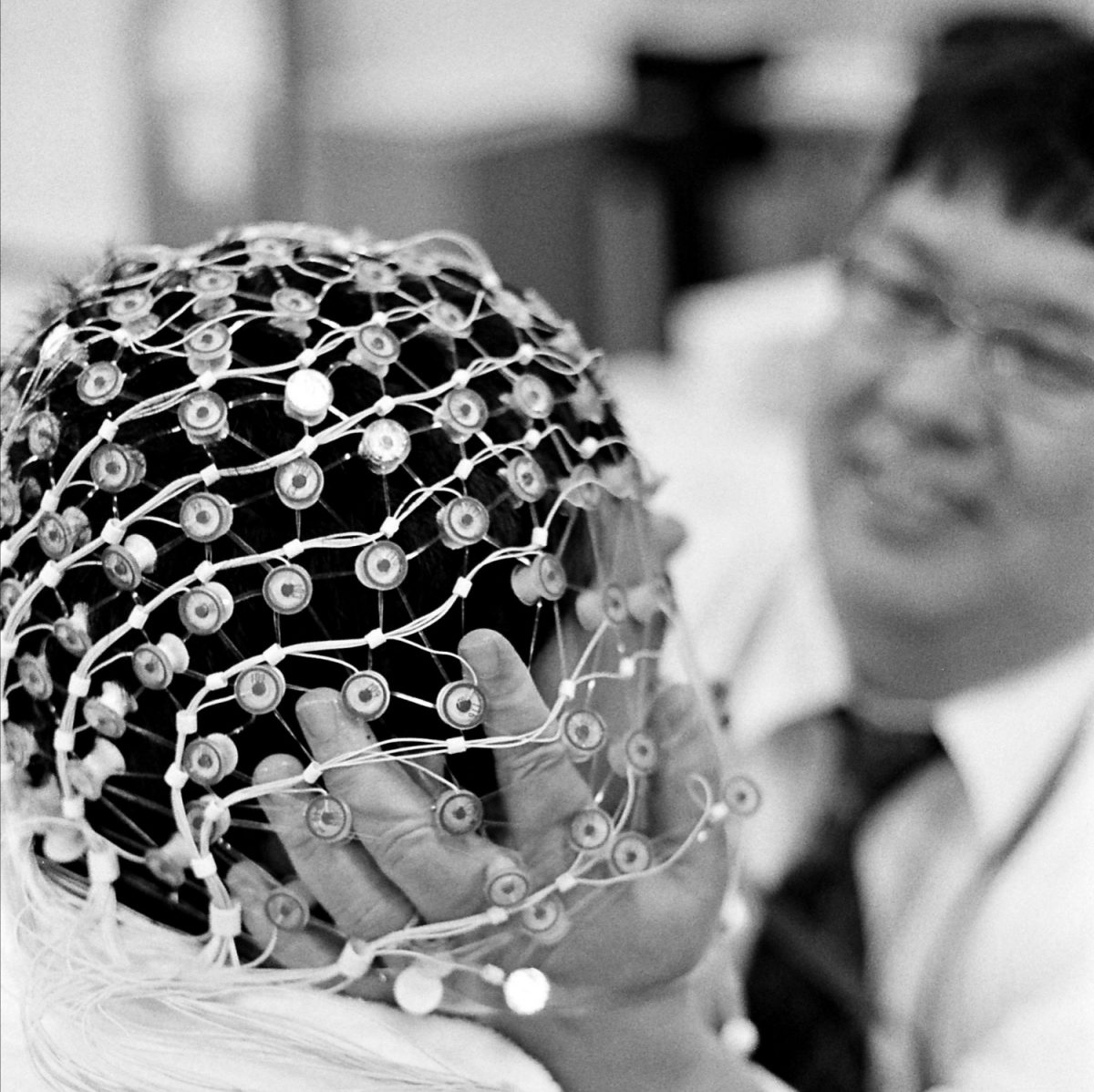

Ehhez hasonló eredményekre jutottak a Sydney Egyetem kutatói is, akik azt próbálták meg feltérképezni, hogy a megtévesztő információk felismerése során vajon milyen pontossággal dolgozik az agyunk, mennyire támaszkodhatunk a tudatos erőfeszítésekre a megkülönböztetés során. A neurológusok elektroenkefalográfia (EEG) segítségével monitorozták a kísérlet alanyainak agyi működését, miközben 50 olyan képet mutattak nekik, amelyek fele valódi emberek arcát, másik fele deepfake arcokat ábrázolt. A résztvevőknek nem árulták el, hogy vannak hamis modellek is a képek között, így a felismerést csak az agyi aktivitás elemzése útján tudták detektálni. A vizsgálatban egy másik csapat is szerepet kapott kontrollcsoportként: ennek a csoportnak a tagjai tudatában voltak a deepfake-ek jelenlétének és tudatos erőfeszítéssel kellett meghatározniuk, hogy mely képeket tartják hamisnak és melyeket valódinak.

Az eredmények szerint azok, akik nem voltak tisztában a feladattal, jelentősen jobban teljesítettek a megkülönböztetés során: az EEG mérések alapján 54%-os biztonsággal ismerte fel az agyuk az "átverést", míg a tudatosan választók csak 37%-os pontossággal voltak képesek megállapítani a deepfake-eket. Bár ez a teljesítmény így is elmarad az átlagos szinttől, de a kutatók szerint statisztikailag megbízható eredménynek számít és rávilágít egy fontos aspektusára a számítógép által generált képeknek: legyenek bármilyen precízen megszerkesztve, az agyunk alapvetően képes dekódolni a hamis mivoltukat felfedő nyomravezető jeleket.

"A tény, hogy az agyunk képes felismerni a deepfake-eket azt jelenti, hogy a jelenlegi deepfake-ek hibásak."

- mondta el Thomas Carlson, a Sydney Egyetem Pszichológiai Iskolájának professzora - "Ha meg tudjuk tanulni, hogyan veszi észre az agyunk a deepfake-eket, felhasználhatjuk ezt az információt olyan algoritmusok létrehozására, amelyek jelzik a potenciális deepfake-et a digitális platformokon, a Facebookon vagy Twitteren."

Az algoritmusok hatékonyságának növelése fontos szerepet játszhat a szintetikus média megtévesztéseivel szemben, ennek érdekében már korábban is történtek előrelépések a programok fejlesztésére többféle mélytanulási módszer alkalmazásával. Érdekes módon éppen azok a módszerek váltak be leginkább a detektálási eredmények növelése terén, amelyek a biológiai ihletésű hálózatokat részesítették előnyben, ilyen például a mesterséges neurális hálózatok egyik típusa, a konvolúciós neurális hálózat. Ez a fajta program egyenesen a betáplált adatokból tanul és nagyon pontos eredményeket ad a tárgyfelismerési feladatok során, ezért az önvezető járművek működtetésében is gyakran használják, valamint, ellentmondásos módon, a szintetikus adatok generálásában is kiemelkedő teljesítményt nyújt. Emellett az ismétlődő neurális hálózatok és ezek egy altípusának, az úgynevezett hosszú rövid-távú memóriának (LSTM) a használata bizonyult különösen hatékonynak a deepfake elleni harcban, azonban az ausztrál kutatók szerint a jövőben akár az algoritmusok nélkül is lehetségessé válhat a hamis képek felismerése.

A neurológusok ugyanis egy újfajta módszert javasolnak a detektálásra: egy fejen viselhető EEG-sisakot, ami monitorozza az agyi aktivitást és így megbízhatóan mutatja azt, hogy az agyunk hogyan címkézi fel az eléje kerülő képeket, ezáltal pedig tudatos figyelem nélkül is lehetővé válik a deepfake-ek felismerése bárki számára. A kutatók ezt elsősorban azok számára tartják alkalmas alternatívának, akik a munkájuk során gyakran találkozhatnak hamis felvételekkel és fontos, hogy megfelelően meg tudják különböztetni a valódit az ál-emberek felvételeitől - a speciális sisak időben figyelmeztetheti őket a megtévesztő tartalmak felbukkanására, ehhez mindössze az agyuk természetes diszkriminatív képességeire kell hagyatkozniuk.

(Fotó: Getty Images/Colin Anderson Productions pty ltd, Flickr/jannem)