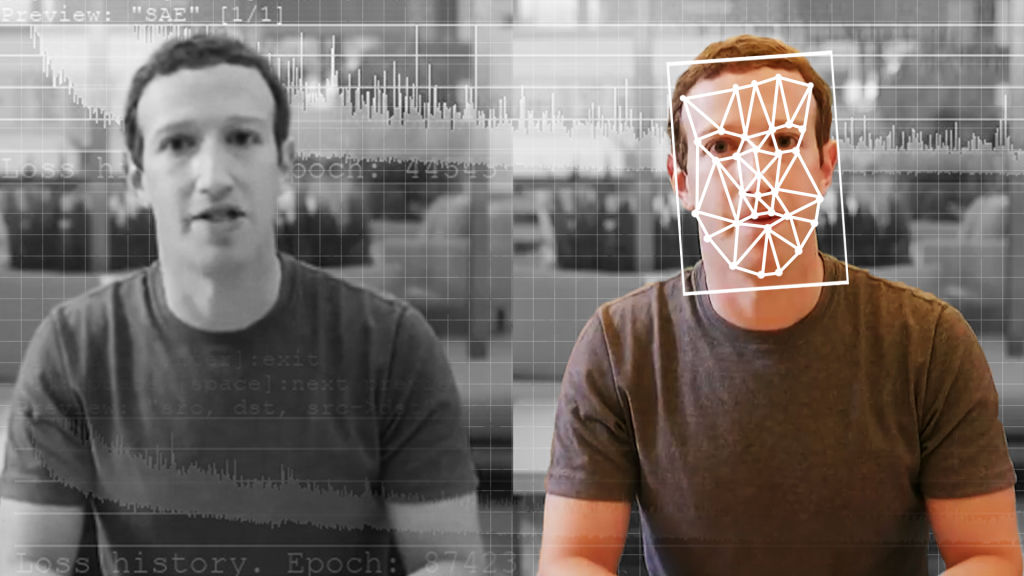

Néhány év alatt hatalmas ugrást értek el a tanuló algoritmusokra épülő mesterséges intelligenciák területén, az eszméletlen mennyiségű adat elemzése által pedig egészen különleges új technológiák kifejlesztésére váltak alkalmassá. Többek között ilyen a fotóanyagok ügyes manipulációja, melyeket leegyszerűsítve akár már egy ingyenes telefonos alkalmazás formájában is bárki kipróbálhat, pedig néhány éve még azt sem gondoltuk volna, hogy az átlag felhasználók számára is elérhető lesznek olyan módszerek, mint például a videofelvételek átalakítását látványos módon művelő deepfake (maga a deepfake szó a „deep learning”, azaz mélytanulás és „fake”, vagyis hamis kifejezésekből ered).

A megfelelő erőforrások birtokában és kellő mennyiségű belefektetett munkával olyan módosított felvételeket készíthetünk, melyek szinte megkülönböztethetetlenek a valódi személyekről készített anyagoktól. Sokan talán még emlékeznek Supasorn Suwajanakorn – 3D-vel és vizuális technológiával foglalkozó vezető szakember – 2018-as TED Talks előadására, ahol a kivetítőn látható négy, szinkronban hivatalosan beszédet tartó Barack Obama mindegyike mesterségesen előállított felvétel volt. Nos, az ilyen és ehhez hasonló áltartalmak detektálásán és kigyomlálásán segíthet az a Facebook által fejlesztett módszer, mely lényegében a saját fegyverüket, vagyis

a mesterséges intelligenciát fordítja a megtévesztő felvételek alkotói ellen.

A technológia fejlődésével a csalók módszerei is egyre kifinomultabbak, így megoldásképp a Facebook és a Michigani Egyetem kutatói közös összefogással létrehoztak egy új módszert, amely nem csupán kiszűri a hamis videókat, de általa azt is megfejthetik, hogy a megtévesztő felvétel milyen generatív modellel született. A csapat azt reméli, hogy lépésükkel olyan fejlesztést alkottak, ami egyrészt eszközt kínál a kutatók és a gyakorlati szakemberek számára az álhírek hatékonyabb kivizsgálására, valamint új távlatokat nyit a jövőbeli kutatások előtt.

Jogosan felvetődhet a kérdés, hogy ezek szerint minden korábbi, a deepfake videók kiszűrésére létrehozott eszköz hatástalannak számít-e, de a fejlesztők szerint nem erről van szó. Sokkal inkább arról, hogy az úgynevezett deepfake detektorokat egy adott generatív modellel készült változatra fejlesztik, olyan eszköz viszont eddig nem szerepelt a kínálatban, ami univerzálisan mindegyiket felismerné. Az úgynevezett fordított mérnöki módszerrel azonban feltárhatják a modell mögött rejlő egyedi mintákat, amelyekkel létrehoztak a deepfake videót.

A modellelemzéssel továbbá megbecsülhetik az egyes deepfake videók létrehozásához használt generatív modellek tulajdonságait, sőt több kamu felvételt is társíthatnak az őket esetlegesen előállító modellhez. Ez információkat nyújt az egyes hamisítványokról, még azokról is,

amelyekről nem volt előzetes információ.

A csapat százezer hamis fotót tartalmazó adatkészlet segítségével képezte ki rendszerét, amelyek száz különböző nyilvánosan elérhető generatív modellből készültek. Eredményeik lényegesen jobbnak bizonyultak a korábbi detektálási modellekhez képest. Hogy a fejlesztés mikor válhat mindenki számára publikussá, arról a kutatók egyelőre nem közöltek információkat, mindenesetre már az önmagában is jó hír, hogy útban van egy ilyen felderítési modell, ami különösen hasznos lehet mindazon a kormányzati szerveknek, rendőrségnek és közösségi oldalaknak, amelyek kétségbeesetten próbálják megakadályozni a hamis információk terjesztését a platformjaikon.

A pornóipar lenne a deepfake fellegvára?

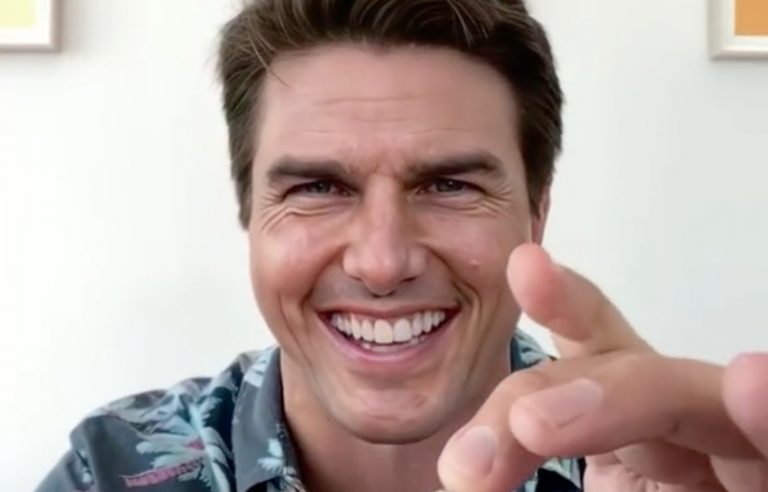

Érdekesnek ugyan érdekes, bár sokakat valószínűleg nem ért váratlanul a Deeptrace kibervédelmi cég kutatásnak azon eredménye, amely szerint a deepfake kamuvideók kilencvenhat százalékát a felnőttfilmes-ipar 'hasznosítja', (erről már mi is írtunk) így szerintük - legalábbis most még - kevésbé kell azon aggódni, hogy rosszindulatú emberek politikai célokra használják azokat. A legtöbb ilyen hamisítvány mindössze arra szolgál, hogy egy-egy híres ember fejét montírozzák egy pornószínész vagy -színésznő testéhez. Az egyik ilyen emlékezetes botrány Scarlet Johansson színésznővel történt még 2018-ban.

A kutatáshoz összesen tizennégyezer-hatszázhetvennyolc áltartalmat vizsgáltak a szakértők, hogy kideríthessék, melyik, vagy melyek azok a népszerű témák, amikben a legtöbb kamuvideó készül, illetve kerül ki a világhálóra. A fáradságos munka eredménye az lett, hogy a felvételek kilencvenhat százaléka az úgynevezett “konszenzus nélkül készült deepfake pornográfia” kategóriájába esett, azaz a hírességek fejét engedélyük nélkül illesztették a pornó szereplőinek feje helyére. Az érintettek többsége - szintén nem meglepő módon - nő:

míg az átnézett videók mindössze egy százalékára montírozták közismert férfiak fejét.

Az viszont még a kísérlet kivitelezőit is ledöbbentette, hogy egy komplett iparág épül ezekre a videókra: különböző weboldalakon tűnnek fel, hirdetések tartoznak hozzájuk, és gyakran fizetni kell értük. A szakértők úgy gondolják, ez azt jelzi előre, hogy nem fognak egyhamar eltűnni a süllyesztőbe. Az viszont mindenképpen pozitívum, hogy egyelőre a politikai élet kevésbé, a pornó viszont sokkal jobban érdekli az internet deepfake-kedvelő szeletét.

A Facebook bekeményít

A Facebook tavaly januárban hivatalosan is szabályzatába foglalta, hogyan kívánja kezelni a jövőben a deepfake videókat és manipulált médiatartalmakat. A problémát több oldalról közelítették meg: egyrészt aktívan kutatják a mesterséges intelligencia által generált tartalmakra jellemző jeleket, másrészt szorosabban együttműködnek majd a hatóságokkal, egyetemekkel és a technológiai szektor más szereplőivel is a hitelességi vizsgálatok során.

A közösségi óriás szerint a manipulált tartalom előállítása még az olyan egyszerű technológiákkal, mint a Photoshop is lehetséges, de természetesen ott vannak az ennél jóval fejlettebb eszközök, például mesterséges intelligencia vagy gépi tanulásos technikák, melyekkel már olyan videók is szerkeszthetők, amik teljesen eltorzítják a valóságot. Ugyan a deepfake videók még nem annyira elterjedtek az interneten, valós fenyegetést jelenthetnek, és

a jövő egyik nagy kihívása lehet a megállításuk.

Kérdés, hogy mi számít hivatalosan deepfake-nek, ezért a vállalat hivatalosan is meghatározta, milyen szempontok alapján tekint valamit annak. Az egyik definíció szerint deepfake-ről beszélhetünk, ha a szerkesztett, vagy mesterségesen előállított tartalom félrevezető, és a videó alanya olyan szavakat mond, amik egyébként sosem hagyták el a száját. Ezzel lényegében meghatározható a mesterséges intelligencia, vagy gépi tanulás által előállított videó fogalma, ami úgy próbál valódinak tűnni, hogy több kép, videó egybeolvasztásával, rétegek egymásra helyezésével áll össze. A szabályzat ugyanakkor nem tér ki arra, hogy mi a helyzet a szatíra, vagy komédia céljából készített manipulált tartalmakkal, ez valószínűleg egy ideig még szürke zónának számít majd.

A Facebook ettől függetlenül nem bízza a véletlenre a dolgot, így a gyanúsnak címkézett videók hitelességét külsős, független tényellenőrzőkkel is vizsgáltatni fogja. Amennyiben úgy tűnik, hogy egy félrevezető és manipulációs céllal készült tartalomról van szó, a Facebook a saját fogalmazása szerint visszavágja a terjedésüket a hírfolyamban, hirdetések esetében pedig egyértelműen betiltja a megjelenést.

(Fotók: Getty Images Hungary)