A milliárd dolláros kérdés, avagy hogyan állapítsuk meg, hogy a kvantumszámítógépünk jól számol?

Azt nem mondhatjuk, hogy a szakemberek elkéstek volna a megoldás kutatásával, hiszen még egy átlagfelhasználó sem cipelte haza és csomagolta ki a személyes kvantumszámítógépét, csak hogy vihesse is vissza a boltba, mert nem jól működik. A paradigmaváltásnak még nagyon a hajnalán járunk, a Google és IBM szupergépeinek legjobbja is egyelőre csak 72 qubites kapacitásra képes, bár a D-Wave Systems bemutatta a kétezer qubites gépét is, ez azonban más célokra lesz használható.

Az IBM január 8.-án jelentette be, hogy sikerült megvalósítaniuk Raleigh nevű gépükkel a Quantum Volume harminckettes szintjét, de mit is jelent ez? A Quantum Volume annak a tesztelésére szolgál, hogy egy gép milyen komplexitású probléma megoldására képes, ezt az cég 2016 óta évente megduplázza, de a mai kvantumszámítógépek még mindig messze állnak attól az általános használatú segédeszköztől, amit a hagyományos számítógépek és PC-k jelentenek. Szemléltetésképpen: 2017-ben Martin Roetteler kiszámolta, hogy egy átlagos 256-bites titkosítást alkalmazó Bitcoin rendszer feltöréséhez kétezer ötszáz qubites számítási kapacitásra lenne szükség. A végső cél, a több millió qubit, ami valóban paradigmaváltást hozhatna, pedig ennél is elérhetetlenebb.

Az viszont tény, hogy a kvantumgépek már itt vannak és működnek.

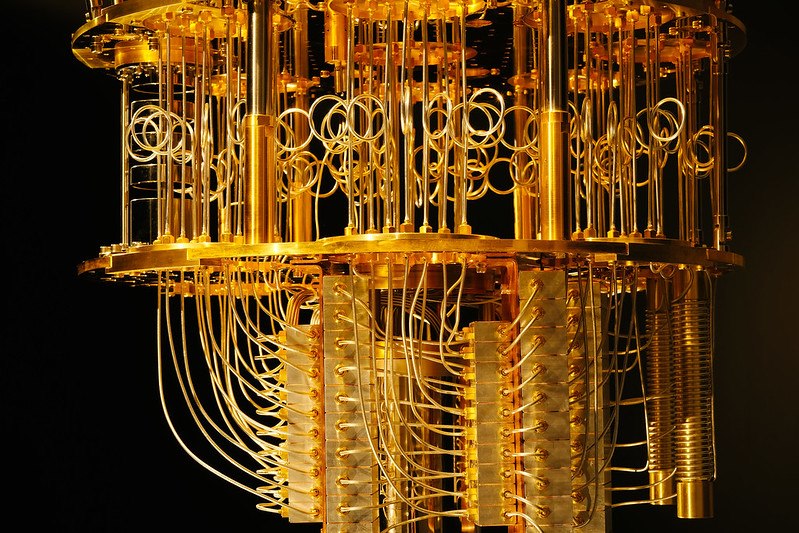

A kvantumbitek szuperpozíciója miatt az egyesekre és nullákra épülő bináris rendszert messze túlszárnyaló műveleti hatékonyságra képesek, tíz qubit 1024 számítást tud szimultán elvégezni. A fejlesztésük és fenntartásuk pedig rengeteg pénzt felemészt, ahhoz, hogy egy aprócska chipet a neki kellemes körülmények között tartsanak, hatalmas kriogenikus hűtőrendszerekre van szükség. A Guardian számítása szerint egy ilyen gép értéke körülbelül tíz milliárd dollár, azaz háromezer milliárd (három billió) forint lehet, ha nem számítjuk a kutatás-fejlesztést. Ennyi pénzért pedig az ember joggal érzi úgy, hogy szüksége van valamilyen garanciára. A hibák szűrésére és processzorok értékelésére már történtek kísérletek, a terület azonban olyan sebességgel fejlődik, hogy mindig van hova tovább lépni. Ahogy Jaques Carolan, az MIT Department of Electrical Engineering and Computer Science (EECS) munkatársa, a legújabb kutatás vezetője mondta: „ A kvantum ellenőrzés idő-kritikussá válik az ipar gyors fejlődése miatt. A technikánk fontos eszközt biztosít a kvantum rendszerek széles körének verifikálásához. Mert, ha milliárdokat akarok befektetni, hogy megépítsek egy kvantumchipet, az biztos, hogy jobban teszi, ha mutat valami érdekeset.” A kutatást az MIT, a Google Quantum AI Laboratory, az Elenion, a Lightmatter és a Zapata Computing szakértői folytatták le.

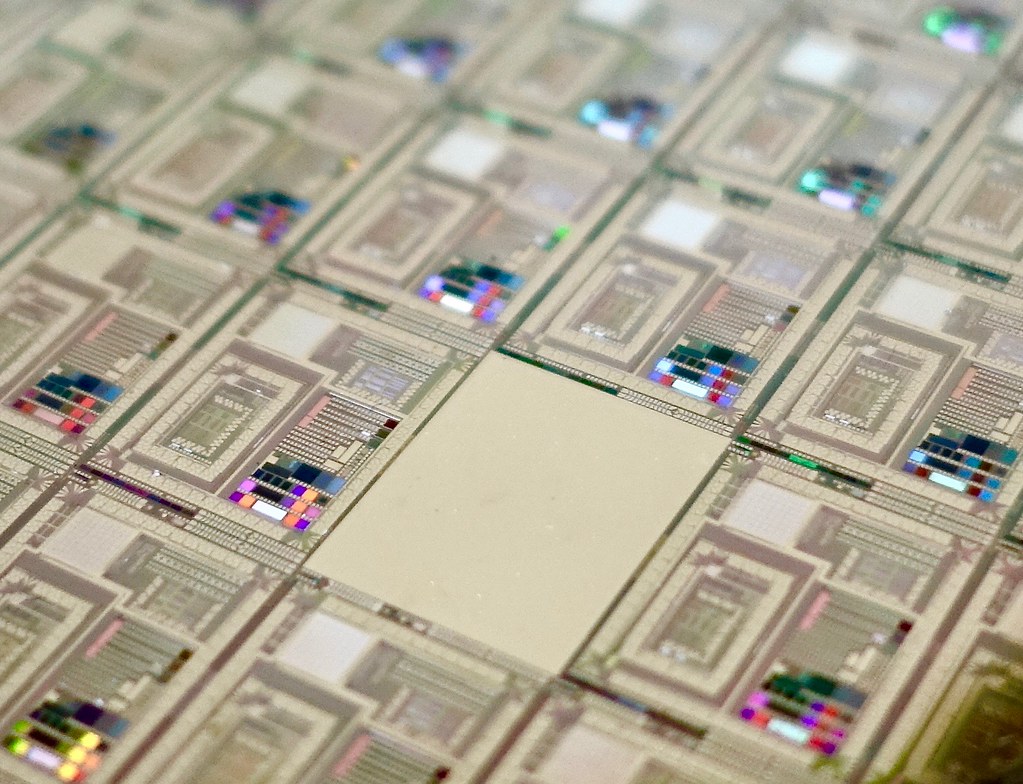

Hogyan épül a kvantumchip?

A teszthez először is megalkották az NISQ, vagyis Noisy Intermediate Scale Quantum chipet. Ez ötven, de akár száz qubitet is tartalmazhat, így képes olyan algoritmusok futtatására, melyek a kvantumfölényt bizonyíthatják. A chip 2/5 milliméter nagyságú, szilikonból készült, százhetven kontroll paramétert, hangolható áramköri alkotórészt tartalmaz. Külső forrásból generált fotonpárokat helyeztek a chipbe, melyek a fázisváltókon áthaladva irányt változtattak és időnként egymás útjába kerültek. A kimenet egy random kvantum állapotot eredményezett, melyet fotondetektor-szenzorokkal mértek be.

Kvantum neurális hálózat: a csodafegyver

Ezután következett az újdonság, a QNN, Quantum Neural Network, mely a neurális hálózatokhoz hasonló módszerrel, rétegről rétegre haladva „hámozza meg” a problémát, ahol minden réteg a kvantumműveletek egy csoportját jelenti. Az NISQ kimenetében kapott eredményt betáplálták a neurális hálózatba. Az első réteg feladata, hogy a kimeneti zajban megtalálja egy darab foton „aláírását”, azaz jellemzőit, melyek a zsúfolt fotontömeg tülekedésében is elkülöníthetővé teszik. Ezután elkülönítik. Majd megpróbálják meghatározni azokat a műveleti lépéseket, melyeken az eredeti betáplálástól kezdve végig kellett, hogy menjen és amelyeknek pontosan egyezniük kell az áramkörök speciális dizájnjával. A következő rétegek mind-mind ugyanezt a feladatot hajtják végre a további fotonokkal, míg végül minden részecske egyedül nem marad és útjuk visszafejthetővé nem válik. Ha ezek a lépések nem egyeznek az eredeti számítási sémával (melyet a kutatók eredetileg betápláltak), valami rosszul működött a kvantumszámítógépben, a szakemberek pedig változtathatnak az áramkörök beállításán.

Boson sampling

A kísérlet bizonyításához a kutatók boson sampling, boson mintavétel programot használták, melynek a lényege, hogy a bemeneti és kimeneti fotonállapotok párba állítását megpróbálják előre megjósolni. Ez a valószínűségi elosztás mintájául szolgálhatna. Ezek azok a típusú feladatok, melyeket a klasszikus számítógépek nem tudnának kiszámítani, de az NISQ chippel lehetségessé válik, a kísérlet pedig eredményesen zárult, a kutatóknak sikerült két fotont elkülöníteniük a boson sampling procedúra során.

„Ez egy nagyszerű tanulmány, mely a nonlineáris kvantum neurális hálózat alkalmazásával megmutatja azokat az ismeretlen műveleteket, melyek a fekete dobozban zajlanak.” – mondta Stefano Pirandola, a Yorki Egyetem professzora, aki a legnagyobb előnyét a felfedezésnek a valós problémák megoldásában látja, nem az elméletekben. Az új rendszer például felhasználható lenne a molekuláris biológia és a biomérnökség területén. „Az álmunk az, hogy alkalmazzuk a fizikai világ érdekes dilemmáinak kibogozásához.”

(Forrás: MITNews, Fotó: Facebook/ IBM Research, Flickr/jurvetson)