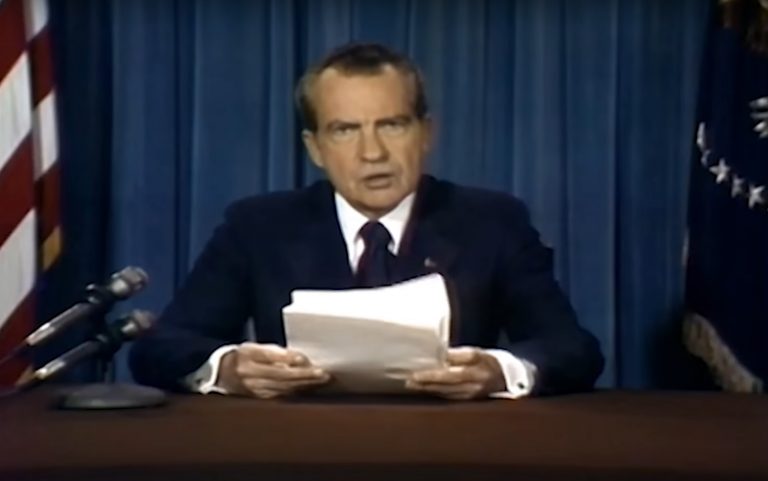

Íme egy videó, amin Richard Nixon bejelenti, hogy az Apollo-11 űrhajósai meghaltak a Holdon

Ahogy azt a holdra szállás ötvenedik évfordulójára készült Player-cikkben már olvashattuk, a hivatalban lévő amerikai elnök, Richard Nixon arra az esetre is készült egy beszéddel, ha az Apollo-11 misszió tragédiával végződik. De más olvasni a leírt szavakat, és más a saját szemünkkel látni és a saját fülünkkel hallani, ahogy az elnök bejelenti, hogy az asztronauták soha nem térnek már haza.

Bár a felvételt látva azt gondolhatnánk, hogy az elnök tanácsadói óvatosságból előre felvették a beszédet, és a tekercsek csak most kerültek elő, ilyesmiről valójában szó sincs:

a videót az első szótól az utolsóig az MIT (Massachusettsi Műszaki Egyetem) kutatói hozták létre deepfake technológiával, hogy szemléltessék, mennyire egyszerű valakinek meghamisítani a szavait.

Francesca Panetta, a film társrendezője a WBUR Newsnak elmondta, hogy ő olvasta fel a szöveget Nixon hanghordozásában, majd a gépi intelligencia segítségével alakították a hangját olyanra, mint az amerikai elnöké volt. A rendező azt is elmondta, hogy akinek megmutatták a filmet, mind azt gondolták, hogy a felvétel valódi, vagy minimum azt, hogy a film készítőinek sikerült szerezniük valakit, aki pont úgy néz ki, mint Nixon.

Stallonétől a pornóig

A mesterséges neurális hálózat által, mélytanulási technológiával létrehozott deepfake videók néhány éve jöttek divatba. A céljuk általában puszta szórakoztatás, például sokak vágya teljesült be, amikor végre megnézhettük, hogy nézett volna ki a Terminator Sylvester Stallonéval a főszerepben, az utóbbi időben viszont egyre sokasodtak az aggasztó jelek a technológia körül.

Az első aggasztó jel az volt, amikor egyre gyakrabban kezdtek el szexvideók előkerülni olyan hírességekről, akikről amúgy soha nem szivárgott ki semmi (vagy kiszivárgott, csak nem az). Mivel róluk volt elegendő mozgókép, így a kezdetleges technológiával főleg a színésznőket lehetett könnyen meghamisítani, de ahogy a deepfake fejlődött, úgy lett egyre könnyebb bárkiről összedobni egy soha meg nem történt szexjelenetet. Ennek a jelenségnek a kicsúcsosodása idén júliusban jött el a DeepNude nevű programmal, amivel már akár egyetlen fotóból is bárkiről létre lehetett hozni egy meztelen videót. Bár a készítők néhány nap után eltüntették a programot a netről, szinte biztosra vehető, hogy ezzel csak ideig-óráig sikerült visszazárni a szellemet a palackba.

Zuckerberg mindent bevall, Obama elküldi a francba Trumpot

És ez még csak a probléma egyik fele, ugyanis az álpornók terjedése közben egyre-másra jöttek ki azok a felvételek is, amiken egy híres ember (jellemzően politikus) mond teljes baromságokat, vagy a meggyőződésével ellentétes dolgokat. Hogy csak három példát említsünk:

Mark Zuckerberg bevallja, hogy gátlástalanul visszaélnek a felhasználók adataival és legféltettebb titkaikkal

Barack Obama nyilvánosan kimondja, hogy Donald Trump egy szarházi alak

Donald Trump pedig bejelenti, hogy felszámolták az AIDS-et

Ezekről a videókról még a megjelenésük pillanatától lehetett tudni, hogy hamisak (mivel a készítőik elárulták), de ne legyenek illúzióink: ez nem marad így örökre. Nem nehéz belátni, hogy egy olyan korban, amikor az álhírek könnyebben terjednek, mint a nátha, mekkora információs káoszt okozhat, ha a deepfake technológia eléri azt a szintet, amikor percek alatt készíthető bárkiről egy videó, akár a telefonunkon is, ahol azt mondatunk ki vele, amit csak akarunk. Ezzel együtt pedig hamarosan az is ugyanilyen általános lehet, hogy ha valakiről előkerül egy kellemetlen videó, semmi mást nem kell mondania, mint azt, hogy: deepfake.

Pedig a technológiában rejlő lehetőségek tényleg fantasztikusak. Elég csak abba belegondolni, hogy hamarosan talán teljesen élethűen rekonstruálható lesz bármilyen történelmi pillanat, ha akár csak egyetlen fénykép is fennmaradt róla. Ezek az előnyök viszont eltörpülnek a veszélyek mellett, amit a deepfake magában hordoz.

Akár tetszik, akár nem, teljesen világos, hogy - ahogy az írott hírek esetében már bekövetkezett - hamarosan a mozgóképeknél is teljesen újra kell értékelnünk, hogy mit fogadunk el hitelesnek, a hangfelvételeknél pedig ez a pont már talán el is érkezett.

A feladat pedig nem lesz könnyű: bár a szakértők már dolgoznak olyan programokon, amik a neurális hálózatok segítségével leplezik le a neurális hálózatok által létrehozott deepfake-videókat, ám egyelőre jól láthatóan a hamis videók állnak nyerésre. Pláne, hogy ehhez még high-tech algoritmusokra sem feltétlenül van szükség. Májusban villámgyorsan terjedt el az interneten egy videó, amin Nancy Pelosi, az amerikai kongresszus demokrata házelnöke látszólag részegen tart beszédet. A videót maga az amerikai elnök, Donald Trump is megosztotta a Twitteren azzal a kommentárral, hogy "Pelosi dadog a sajtótájékoztatón", holott valójában csak annyi történt, hogy valaki 25%-kal lelassította az eredeti felvételt.