Közeleg a technológiai szingularitás - saját chipjét tervezi a mesterséges intelligencia, az embereknél ezerszer gyorsabban

Vernor Vinge amerikai matematikus így írta le a technológiai szingularitást az 1993-as, NASA által szervezett Vision-21 Szimpóziumon:

"Olyan változás határán állunk, amely az emberi élet kifejlődéséhez hasonlítható itt a Földön.

A pontos oka ennek a változásnak a közelgő megalkotása az emberinél is hatalmasabb intelligenciával rendelkező entitások technológiájának. A tudomány ezt az áttörést többféle módon érheti el (és ez még egy ok a meggyőződésre, hogy az esemény be fog következni):

- Számítógépek, melyek "ébren" vannak és emberfelettien intelligensek

- A nagy számítógépes hálózatok és használóik "megvilágosodnak", mint emberfelettien intelligens entitások

- A gép/humán interfészek olyan közelivé válnak, hogy joggal lesznek emberfelettien intelligensnek nevezhetőek

- A biológiai tudományok eszközöket biztosítanak a természetes humán intellektus fejlesztéséhez

Az első három lehetőség a komputer hardverek fejlődésétől függ[...]"

Vinge a szingularitás eseményének bekövetkeztét valamikor 2005 és 2030 közé helyezte el és úgy gondolta, egyáltalán nem légből kapott ötlet, hogy az emberi intelligencia által teremtett gépek az alkotóiknál radikálisabban gyorsabbá válnak, elvégre az ember is képes az evolúció lassú, természetes szelekcióra alapozott ütemét messze felülmúlni a problémamegoldások során, a gépeket pedig direkt azért építjük, hogy az nálunk is sebesebben oldják meg a feladatokat. Mivel a szingularitást egyfajta emberfeletti entitás létrejötteként szokták meghatározni, illetve egy olyan pontként, ahol a fejlődés annyira felgyorsul, hogy a jövő előrejelezhetetlen transzformációkat hoz, ezért egyelőre erős túlzás lenne azt állítani, hogy elért a technológia erre a pontra, de Vinge jóslatát figyelembe véve, miszerint az áttörést a hardver fejlődése fogja elhozni, egy lépéssel most közelebb került hozzá a világ, hogy belépjen a változás előszobájába.

A Google Research Brain Team kutatói június 9-én publikálták a tanulmányt arról a kísérletről, amelyek során egy mesterséges intelligencia alapú algoritmusra bízták a chipek készítésének egyik legidőrablóbb feladatát és a program eredményei messze felülmúlták a humán mérnökökét. Az áramköröket tartalmazó lapkák alaprajzának pontos megtervezése nyolc-kilenc hónap munkájába is telhet a szakértők számára, mivel a különböző funkciókat ellátó blokkok egymás mellé helyezésének szabályait három nagyon fontos kritérium vezérli:

- az energiahatékonyság, vagyis az energiafelhasználás minimalizálása

- a teljesítmény maximalizálása

- és a hely minél jobb kihasználása

Ennek eléréséhez először elektronikus tervezést automatizáló (EDA) eszközöket használnak, majd manuálisan rendezik el a kapott mátrixtervek alapján az építőegységeket. Mivel a sztenderd cellák, a logikai kapuk később kerülnek a chipre, ezért első körben a makroblokkokat, memória egységeket helyezik el, de nem mindegy, hogy a kész lapkán a blokkokat összekötő huzalok milyen hosszúságúak lesznek, a cél hogy minél rövidebbek legyenek, az egységek minél közelebb kerüljenek egymáshoz, de ez ne váljon a performancia kárára.

A kutatók egy olyan mesterséges intelligencia algoritmust bíztak meg ennek a nehéz feladatnak a kivitelezésével, amely nem előre beprogramozott módon, hanem megerősítéses tanulással, tehát tapasztalatból tanulta meg, hogy melyik a helyes megoldás a tervezés során. A jó megoldást ezeknél az algoritmusoknál jutalom kell, hogy kísérje, másképp nem lesz világos számukra a cél és összezavarodhatnak a prioritásokat illetően. Ebben az esetben a jutalom, vagyis a megerősítés az utolsó lépésnél következett a huzalok hossza, a zsúfoltság és a sűrűség negatív összértékeként, aminek megfelelő értéke azt jelentette, hogy mindezeket optimálisan rendezte el a MI. A kutatók leírása szerint egy minden chipre alkalmazható általános tervezési irányelv elsajátítása rendkívül komplex folyamat, ami megelőzi még a hagyományosan az egyik legbonyolultabb játéknak tartott Gót is: míg a játékban 10 háromszázhatvanadik hatványa a lehetséges variációk száma a kövek potenciális elhelyezését illetően, addig egy chip alaprajz tervezésének optimalizálása 10 kétezerötszázadik hatványát is meghaladó számú különböző konfigurációra ad alkalmat.

A mesterséges intelligencia programot tízezer már meglévő terven gyakorlatoztatták és a végső teszten sikerült hat óra alatt elrendeznie öt olyan blokkot, amelynek mindegyike több száz makro és több millió sztenderd cellát tartalmazott. Az általa tervezett chipek a minőségellenőrzésen is jól szerepeltek, sőt, bizonyos tekintetben felülmúlták az emberekét, mivel olyan rendhagyó mintákat is tartalmaztak, amelyek az emberi munkákban nem bukkantak fel. A humán szakértők hónapokat felemésztő munkája így a töredékére csökkenhet a jövőben, ha a mesterséges intelligenciára bízzák a kivitelezést, amit a Google már meg is tett, a Tensor Processor Unit elkészítéséhez már az új algoritmust használják a laborokban. A TPU pedig nem máshoz kell, mint a hatékonyabb mesterséges intelligencia rendszerek létrehozásához.

A Google Brain víziója pontosan ez volt a kutatással, egy MI-t tervező MI megalkotása

- mondta Anna Goldie, a kísérlet résztvevője a Nature-nek. "Most, hogy a gépi tanulás ilyen tehetségessé vált - és ez a hardverek és rendszerek fejlődésének köszönhető - használhatjuk a mesterséges intelligenciát arra, hogy olyan rendszereket és hardvereket tervezzen, amelyeken a jövő mesterséges intelligencia algoritmusait lehet futtatni."

(Fotó: Getty Images/carloscastilla, Pixabay, Wikimedia Commons)

További cikkek a témában:

A Microsoft kutatói szerint a világegyetem úgy működik, mint egy gépi mesterséges intelligencia

Ez pedig azt is megmagyarázná, miért nem sikerült még kidolgozni egy mindent magában foglaló, egységes fizikai világképet.

A Microsoft kutatói szerint a világegyetem úgy működik, mint egy gépi mesterséges intelligencia

Ez pedig azt is megmagyarázná, miért nem sikerült még kidolgozni egy mindent magában foglaló, egységes fizikai világképet.

Kvantumchipet terveztünk az IBM kutatójával

Zlatko Minev kvantumfizikus, aki 2019-ben 'megmentette' Schrödinger macskáját, most megmutatta, hogyan tudnak egyszerű halandók is kvantumchipet tervezni pár egyszerű lépésben.

Kvantumchipet terveztünk az IBM kutatójával

Zlatko Minev kvantumfizikus, aki 2019-ben 'megmentette' Schrödinger macskáját, most megmutatta, hogyan tudnak egyszerű halandók is kvantumchipet tervezni pár egyszerű lépésben.

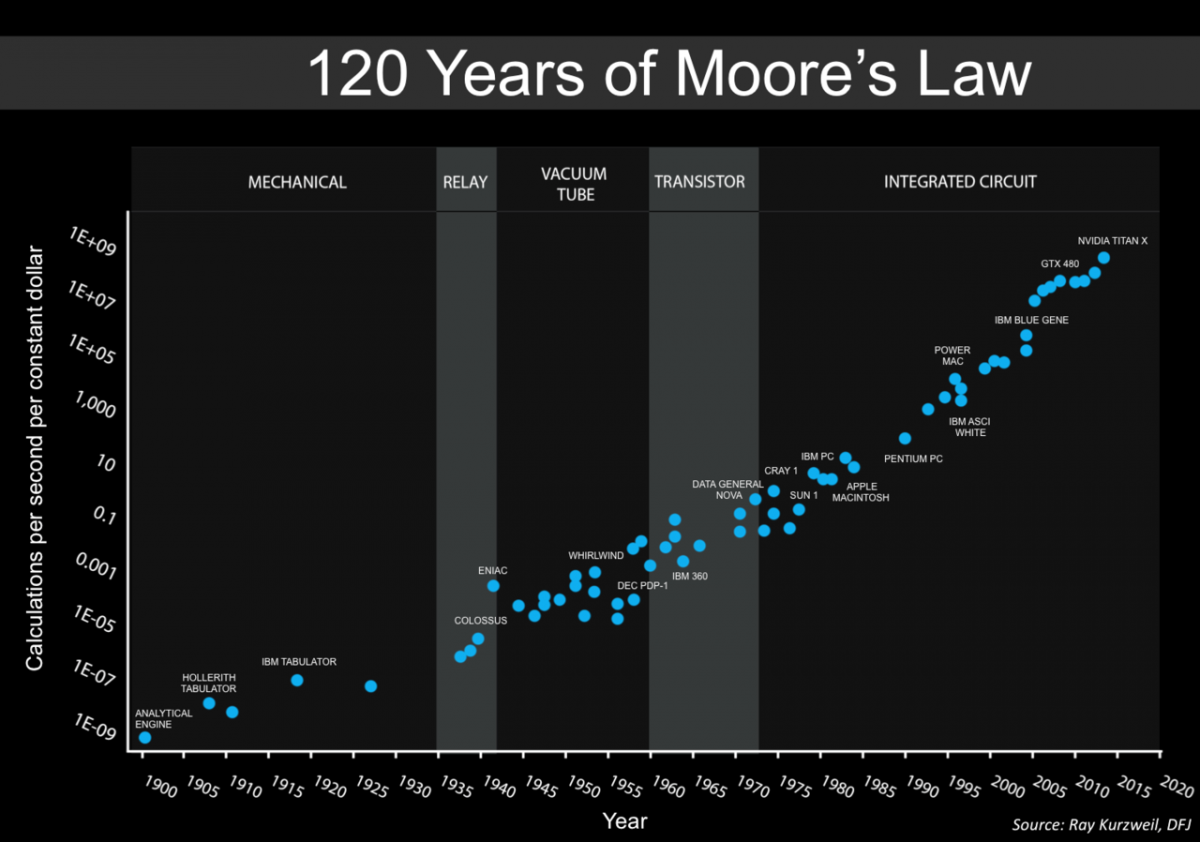

Vajon valóban elbukik a Moore-törvény, vagy van még tovább?

Moore-törvénye évtizedekig az informatika világítótornyaként jelezte előre a technológiai fejlődés ütemét, a bukását sokan megjósolták, de eddig még mindig megúszta.

Vajon valóban elbukik a Moore-törvény, vagy van még tovább?

Moore-törvénye évtizedekig az informatika világítótornyaként jelezte előre a technológiai fejlődés ütemét, a bukását sokan megjósolták, de eddig még mindig megúszta.