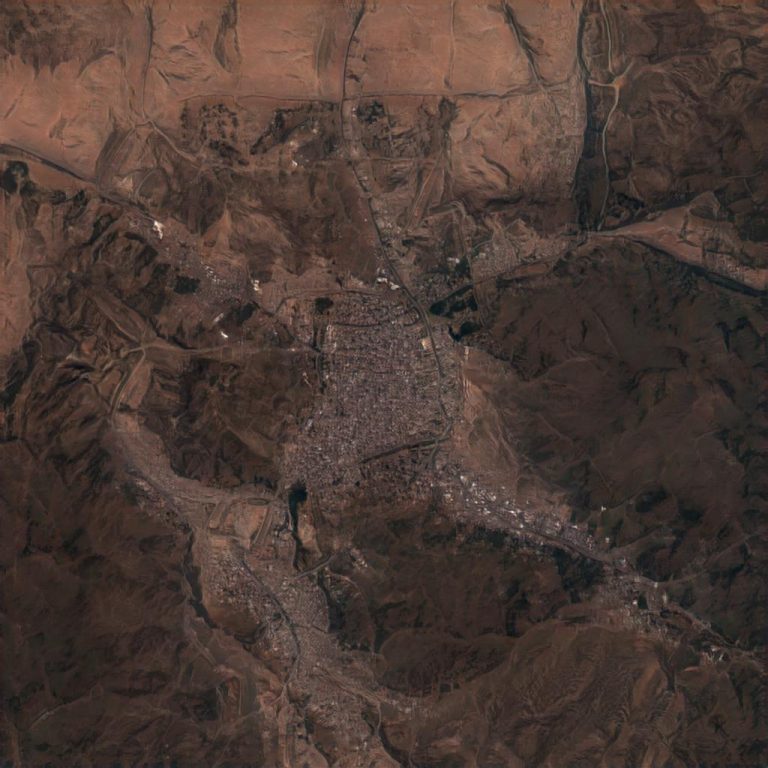

Ha szeretnénk röviden és leegyszerűsítve összefoglalni, hogy mi az a deepfake, akkor a fentieknek megfelelően azt mondhatjuk, hogy olyan hamis, jellemzően képanyag, amit mesterséges intelligencia segítségével hoztak létre. A végeredmény adott esetben „jópofa” lehet, mint a mesterséges intelligencia által alkotott, a valóságban sosem létezett autók és macskák, időnként felkavaró, mint a sosem létezett emberek, vagy akár kifejezetten ártalmas, mint amikor valakinek az arcát cserélik ki egy pornószínész arcára egy-egy jelenetben. Hogy a mesterséges intelligencia mire képes ma már, azt egy egyszerű webböngészőben is megtekinthetjük, a lenti cikkben össze is gyűjtöttünk egy csokrot ezekből, de egy nemlétező várost használtunk ennek a cikknek az illusztrálására is.

A deepfake technológia különböző területeit pedig ennek megfelelően régóta tanulmányozzák, egy új tanulmány azonban most a deepfake műholdképek veszélyeivel foglalkozott a szerzők szerint valószínűleg az első, ilyen célú empirikus kutatás keretein belül. Az első kérdés, hogy milyen veszélyt jelenthet egyáltalán egy deepfake műholdkép. Aki átbogarászta a fentebb linkelt cikket, abban is találhat sosem-létezett-város generátort, ami érdekes látványosság, de kifejezetten ártalmatlannak tűnik az egy adott személy lejáratására is alkalmas deepfake pornóhoz képest. Pedig a hasonló műholdképekkel pontosan olyan sikeresen lehet akár emberek nagyobb csoportját is félrevezetni, mint a technológia egyéb területen történő felhasználásával (vagy akár azoknál sikeresebben is – de erről később). Ennek egyik módja lehet például áradások, bozóttüzek vagy egyéb természeti katasztrófák hamisítása. Katonai szempontból veszélyes lehet például egy nemlétező híd megjelenése ezeken a képeken, de szóba kerülhet olyan emberi jogi visszaélés, mint akár az ujgur munkatáborok eltüntetése ezekről a képekről, hiszen például ezekről egyáltalán csak a műholdaknak köszönhetően tudunk. Vagyis a deepfake technológia a földrajzi információs rendszerek (GIS) korában számtalan módon okozhat kárt.

Bo Zhao, a Washingtoni Egyetem professzora pedig a kutatásával elsősorban épp ezt a veszélyt kívánta tudatosítani. Mint a professzor írja, a térképek különböző célú meghamisítása olyan régre nyúlik vissza, mióta térképek egyáltalán léteznek. Ezeknek célja lehetett az ellenséges haderők összezavarása, de akár a szerzői jogi védelem. Erre az említett példa a papírváros, tehát egy kitalált, valóságban nem létező város feltüntetése a térképen, amit ha lemásolt valaki a teljes térképpel együtt, akkor a bíróságon lehetett rá hivatkozni, mint bizonyítékra a másolással kapcsolatban. A műholdképek és a deepfake technológia kapcsán azonban az eddigiekhez képest két veszély sejlik fel: egyrészről a műholdképek mögött az emberek kormányokat, szakértőket, bonyolult technológiai rendszereket feltételeznek, így ezeket nagyon sokan tartják perdöntően hitelesnek. Másrészről a mesterséges intelligencia segítségével hamis műholdképeket könnyebb létrehozni, mint akár egy emberi arcot. Vagyis a műholdképeket rendkívül hitelesnek vélik az emberek általában, pedig ezeket igen könnyű „hamisítani”.

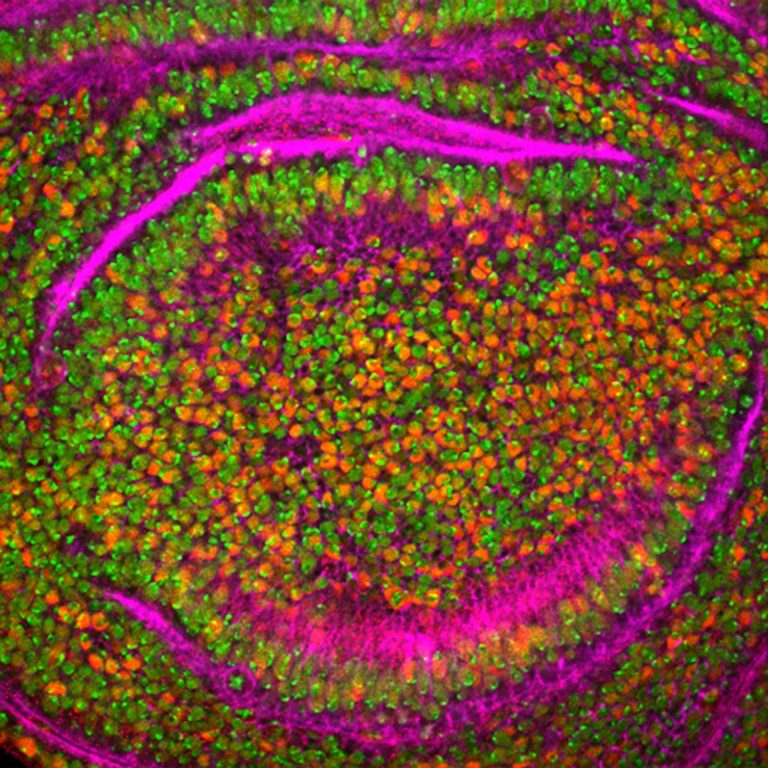

Zhao és kollégai a tanulmányhoz felépítettek egy olyan deep learning technológiára épülő rendszert, amilyeneket tehát mi is összegyűjtöttünk a fenti linken, majd készítettek egy szoftvert, amely képes ezeket a hamis felvételeket kiszűrni. Azonban, ahogy az a deep fake technológiákra általában igaz, ezzel egy végtelen fegyverkezési verseny vette kezdetét, hiszen ahogy javulnak a hamisítványok, úgy kell folyamatosan fejleszteni az ezek kiszűrésére alkalmazott technológiákat. A tanulmány legfőbb célja ugyanakkor éppen az volt, hogy erre a veszélyre – tehát a deepfake műholdképek lehetséges megjelenésére felhívja a szélesebb közvélemény figyelmét.

(Kép: thiscitydoesnotexist.com)

További cikkek a témában: