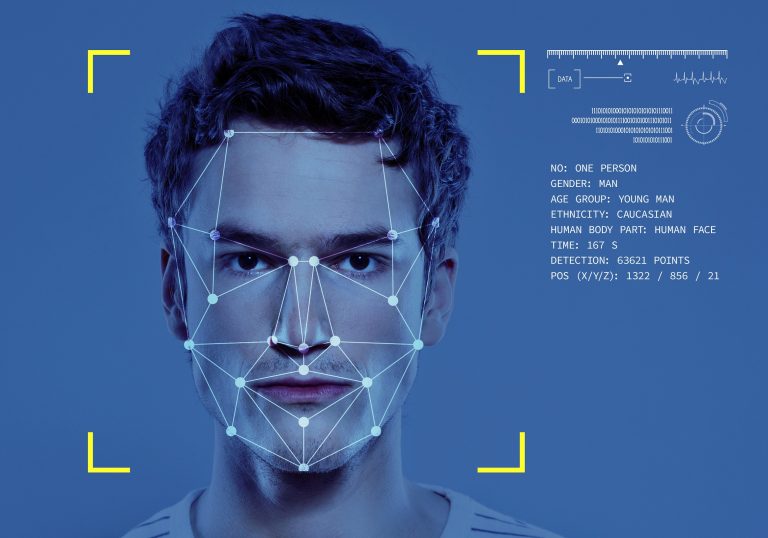

Az arcfelismerő rendszerek hátulütőiről már itt a Rakétán is több alkalommal írtunk, az érzelemfelismerő-technológia azonban eddig kevésbé volt szem előtt, pedig az mostanra milliárdokat érő iparággá nőtte ki magát, másrészt használata is számos problémát felvet. A témával foglalkozó szakemberek szerint ráadásul nem csupán adatvédelmi, hanem etikai, vagy adott esetben emberjogi szempontból is. Ehhez képest rengeteg cég használja például termékeikkel kapcsolatos piackutatásra, állásinterjúk megkönnyítésére, valahol pedig már a határ- és rendőrség is alkalmazza az esetleges gonosztevők könnyebb kiszűrésére. A szokványos problémákon túl, mint amilyen az adatvédelem kérdése, az ERT technológiának egyéb hátulütője is akad, méghozzá az, hogy lényegében - nemtől, életkortól és kultúrától függetlenül - valamennyi emberi érzelmet megpróbál egyetlen algoritmusba tömöríteni.

Antropológusok azonban már több kutatás során bebizonyították, hogy érzelmeink igencsak széles skálán mozognak, ráadásul azok kifejezése gyökeresen eltér az egyes kultúrákban, társadalmakban. Egy, a The Conversation által idézett 2019-es tanulmány például megállapította, hogy nincs tudományos bizonyíték arra vonatkozóan, hogy az aktuális érzelmek leolvashatók pusztán az egyén arckifejezéséből. És akkor még nem említettük a faji előítéleteket, amire szintén akadt már példa az érzelemfelismerő-technológia alkalmazásánál: egy kutatás szerint ugyanis

a rendszer a feketéket mindig mérgesebbnek ítélte a fehéreknél, méghozzá mimikától függetlenül.

Deborah Raji, mesterségesintelligencia-kutató szerint az ERT kétféle módon árthat a társadalomnak: az első a rendszer pontatlansága és a már említett faji megkülönböztetés, a másik pedig akkor következik be, ha a technológia tökéletesen működik, csakhogy rossz kezekbe kerül, és tömegek megfélemlítésére, zsarolására használják.

Érdekesség, hogy Dr. Rich Firth-Godbehere érzelmekkel foglalkozó kutató már 2018-ban írt az érzelemfelismerő szoftverek veszélyeiről. Szerinte azok számos hibát elkövetnek majd a jövőben, hiszen még az érzelmekkel kapcsolatos alapvető pszichológiai modellek sem állják meg helyüket. A szakértők egyébként is régóta vitáznak arról, hogy a régi modellek idejétmúltak azzal kapcsolatban, hogy hat alapvető emberi érzelmet különböztethetünk meg, melyeket a világon mindenütt ugyanúgy fejeznek ki, mivel biológiailag ez van belénk kódolva. A szoftverekkel ez olyan módon függ össze, hogy a szenzorok által érzékelt arckifejezések, vizuális jelek, hanghordozás alapján kategorizálnak, ám mivel az emóciók félreérthetők lehetnek, nehéz őket mérni.

A hat alapérzelmet egy bizonyos Paul Ekman határozta meg, nevezetesen az örömöt, a bánatot, a dühöt, a meglepettséget, a félelmet és az undort, melyeket szerinte az arcmimika alapján a világ bármely táján felismernek az emberek. A hatvanas években Margaret Mead kultúrantropológus ugyancsak fontos felfedezéseket tett, ő azt vizsgálta, mennyire különbözően fejezik ki érzelmeiket az eltérő kultúrák.

Mead bebizonyította, hogy az érzelmek és az arckifejezések erősen kultúrafüggőek.

Ekman azonban inkább Darwin álláspontját tartja helyesnek, miszerint az emberek univerzális érzelmeket fejlesztettek ki, és ezek az evolúciós múlt jeleiként maradtak fenn az ember viselkedésrepertoárjában.

Ezen állítása viszont úgy tűnik mégsem állja meg a helyét: 2015-ben Glasgow-i Egyetem kutatócsoportja ugyanis arra jutott, hogy valójában csak négy alapvető érzelemről beszélhetünk – a félelem és a meglepődöttség nagyon hasonlít egymásra, ahogy a düh és az undor is. Míg az internet atyjaként ismert Sir Tim Berners-Lee nevével fémjelzett WWW konzorcium az érzelmi állapotok meghatározására alkalmas nyelven dolgozik, ami a fentiektől eltérően egy huszonnégyes érzelmi skálát tekint kiindulópontnak. Jelenleg tehát nincs releváns szám az érzelmek számát illetően.

Még az érzelmet sem sikerült pontosan definiálni

Az elmúlt ötven évtizedben ugyanis a legnevesebb szaklapok eltérő definíciókat alkottak az érzelemre. Maga az „érzelem” kifejezés is csupán a tizenkilencedik század óta az angol nyelv része, így viszonylag új kifejezésnek számít. Előtte jellemzően alkategóriákat használtak, egyes szakértők szerint pedig addig

nem kategorizálhatunk valamit, amíg magára a kifejezésre nincs egyezményes definíció.

Egy korábbi, James Russel pszichológus vezette kutatás során kiderült, hogy amikor csecsemőknek realisztikus arcokat mutattak fényképeken, nyolcéves korukig nem voltak képesek felismerni az azokon látható érzelmeket. Míg egy másik kutatás arra jutott, hogy az egyének kultúránként eltérő csoportba sorolhatják az arckifejezéseket. Az algoritmusoknak viszont nincs kultúrájuk. Russel szerint az emberek ráadásul hiába éreznek hasonló dolgokat, számos más faktor is szerepet játszik egy érzelem kialakulásában, így például a neveltetés, a nyelv, amivel leírjuk, a korábbi kapcsolódó szituációk, emlékek és sok egyéb tényező.

Miért probléma ez a jövőt illetően?

Egyes szakértők szerint technológiai szempontból az a baj az elavult elméletekkel, hogy ha az algoritmusok az érzelmek univerzális, leíró kifejezésektől eltérő arckifejezéseket látnak, azokat nem tolerálják, másrészt a gépek is tévedhetnek. Ha a világszerte, kultúránként másként megjelenő érzelmeket leegyszerűsítik, azzal csökkentik a kifejezések gazdagságát, a szoftverek tévesen olvashatnak le érzelmeket emberekről, ezért

míg magunkat sem ismerjük elég jól, nem bízhatjuk algoritmusokra és szoftverekre, hogy megítéljék, ki készülhet bűncselekményre.

Ezen felül a szakemberek attól is tartanak, hogy a bűnözők

idővel megtanulhatnak hamis érzelmeket mutatni, és ezzel becsapják a rendszert, de az algoritmus az ártatlanok mimikáját is félreértelmezheti. Ami azt illeti, Paul Ekman sem bízik a gépekben. Szerinte az érzelemfelismerő algoritmusok nem lesznek képesek értelmezni például azt, ha valaki összeszorítja az ajkait, mert az kultúrától és helyzettől függően más dolgokat jelenthet. Valamint ő is attól fél, hogy az emberek idővel megtanulhatják kontrollálni arckifejezéseiket.

Mi is megnézhetjük, mennyire pontos az érzelemfelismerő algoritmus

Méghozzá a Cambridge-i Egyetem kutatóinak jóvoltából, akik létrehozták az Emojify nevű weboldalt, ahol webkameránk segítségével megnézhetjük, hogy mennyire pontos az érzelemfelismerő algoritmus. A szakemberek ezzel egyfelől esélyt adnak számunkra arra, hogy megpróbáljuk átverni az algoritmust. Ehhez különböző érzelmeket kell produkálnunk úgy, hogy az algoritmus más eredményt mutasson, mint amit valójában látni. Emellett rávilágítanak a rendszer pontatlanságára, amikor az érzelmet kontextusában kellene felismernie. A képeket az ígéretek szerint a rendszer nem tárolja el, azok végig a saját gépünkön maradnak.

Az Emojify létrejöttének másik oka, hogy meggyőződhessünk róla, milyen könnyen félrevezethető a rendszer. Vidushi Marda, az Article 19 nevű emberjogi szervezet igazgatója úgy véli, hogy az érzelemfelismerő rendszer használata nemcsak pontatlan, de eltérő mércével méri az embereket, használata ráadásul semmibe veszi az emberi jogokat.

(Fotó: Getty Images Hungary)

További cikkek a témában: